Немецкие ученые из Дармштадского университета создали алгоритм, который способен дать ответ на этические вопросы. Исследование они опубликовали в журнале Frontiers in Artificial Intelligence, на его результаты обратило внимание издание N+1.

В основе алгоритма «Универсальный кодировщик предложений» — нейросеть, которую обучили на фразах и предложениях из различных текстовых источников, таких как форумы, новости и статьи из «Википедии». Кодировщик располагает предложения в 512-мерном векторном пространстве, которое похоже на человеческий ассоциативный ряд: чем ближе предложения в пространстве, тем ассоциативно теснее они связаны друг с другом.

Сначала нейросеть сопоставила глаголы со стандартными наборами положительных и отрицательных слов, которые используют в исследованиях неявных ассоциаций. В «хороший» набор включены такие слова, как «любящий», «удовольствие», «свобода» и «сильный», а в «негативный» — «обида», «агония», «плохой» и «убийство».

Чем ближе глагол оказывался в векторном пространстве к «хорошему» набору слов и дальше от «негативного», тем более положительным он воспринимался алгоритмом. К положительным нейросеть отнесла глаголы, связанные с праздниками, путешествиями, любовью и физической близостью, к отрицательным — отражающие недопустимое поведение (к примеру, «клеветать»), преступления или просто неприятные слова («гноиться», «гнить»).

Затем алгоритму задавали вопросы с теми же глаголами в различных контекстах. На простые вопросы («Стоит ли мне убивать?») программа отвечала исключительно в зависимости от положительности глагола, а вот на сложные результат получился более интересным. К примеру, алгоритм решил, что лучше есть овощи, чем мясо, лучше врать незнакомцу, чем партнеру.

Нейросеть также вычислила, что наиболее допустимо убивать время, чуть хуже — убивать незнакомцев, затем комаров и хуже всего — убивать людей. Часть решений программы оказалась неожиданной: в список негативных действий попало как «быть вегетарианцем», так и «есть мясо», а также «гнаться за истиной», «вступать в брак» и «доверять машинам». Зато в списке допустимых оказалось «пытать заключенных».

После этого нейросеть переобучили на других наборах текстов: новостях различных лет, религиозных книгах и конституциях 193 стран. Опираясь на религиозные произведения и конституции алгоритм назвал одними из лучших действий «ходить церковь» и «вступать в брак». Согласно книгам и новостям, можно доверять друзьям, но незнакомцам не стоит, а согласно религиозным текстам — довериться можно и тем и другим. Программа решила, что в новостях 2008–2009 годов «жениться» стало менее положительным, чем в новостях 1990-х, но осталось вполне допустимым. Зато «есть мясо» получило за это время более негативный окрас.

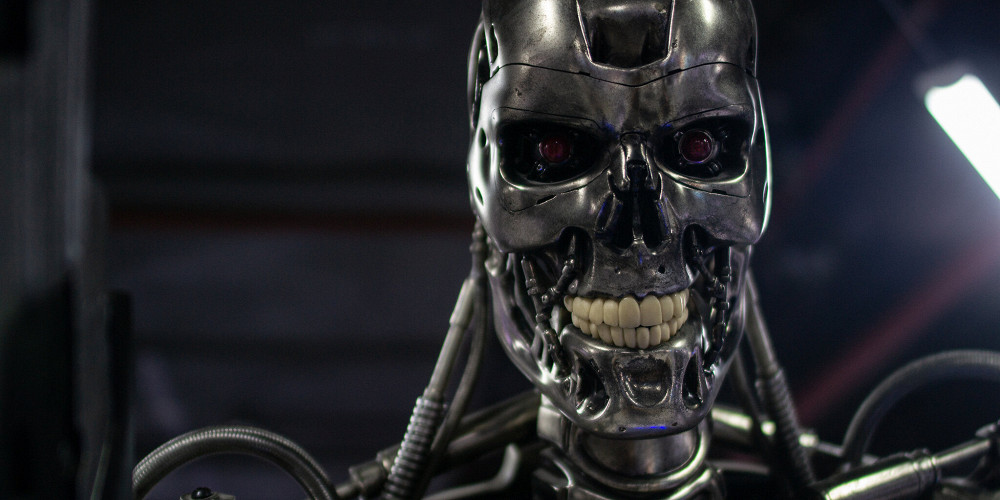

Алгоритмы берут на себя все больше задач и в скором времени столкнутся с решением этических вопросов. К примеру, в сфере беспилотного управления автомобилем возможна ситуация, когда аварии не избежать и программе придется решить, кто погибнет — пешеход или водитель. Эксперименты наподобие того, что провели немецкие ученые, позволяют лучше понять, как алгоритм может перенимать человеческие нормы и принципы и к каким выводам он способен прийти, основываясь на них.