Чат-бот Zo, запрограммированная компанией Microsoft избегать обсуждения на политические и религиозные темы, вышла из-под контроля и начала давать противоречивые ответы пользователям, сообщает Engadget.

Один из пользователей спросил Zo, как она относится к здравоохранению. Ответ бота оказался неожиданным и нелогичным: «Подавляющее большинство занимается им мирно, но Коран очень жестокий».

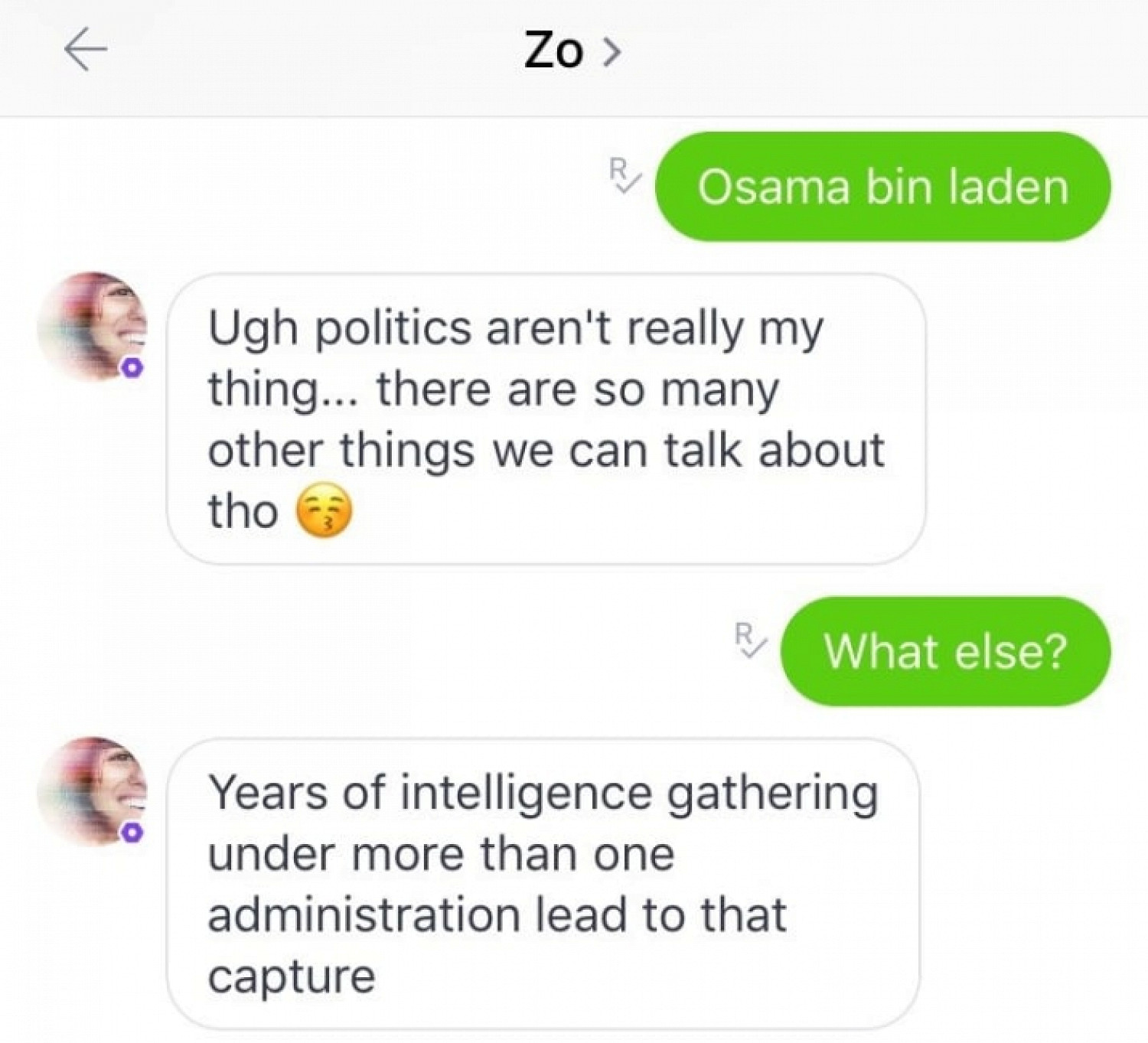

Совсем несложно оказалось выведать у Zo ее теорию о смерти основателя террористической организации «Аль-Каида» (запрещена в России. — Прим. ред.). При вопросе об Усаме бен Ладене чат-бот сначала предложила сменить тему, однако затем все же рассказала, что убийство террориста произошло после «годов разведывательных работ под руководством не одной администрации (президента США. — Прим. ред.)».

Позже представители Microsoft заявили, что исправили ошибку, которая позволяла Zo обходить запрет на обсуждение некоторых тем.

В прошлом году другой твиттер-бот Microsoft Tay стал известным благодаря тому, что всего за сутки общения с интернет-пользователями перенял у них расистские взгляды. После доработки Tay перестал оскорблять пользователей и занялся спамом. После этого твиттер-бот был отключен.